DeepSeek 开源周第一天开云app官网下载入口,降本大法公开——

FlashMLA,奏凯冲破 H800 缱绻上限。

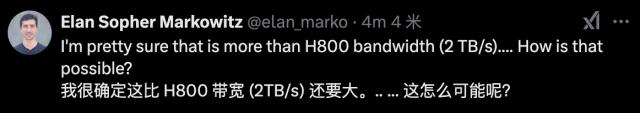

网友:这如何可能??

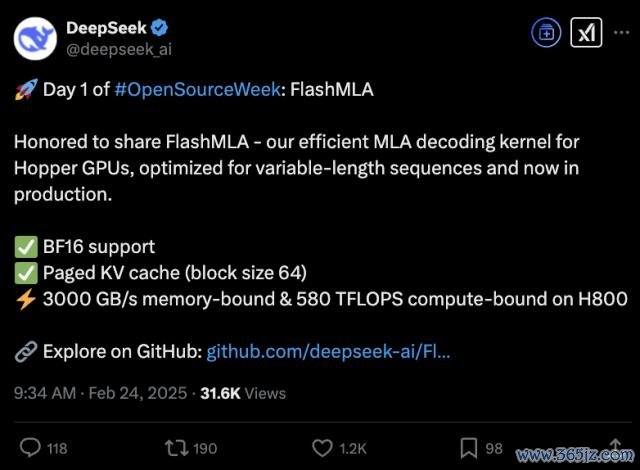

它是为 Hopper GPU 竖立的高效 MLA 解码内核,特意针对可变长度序列进行了优化,现在也曾干与分娩。

MLA,恰是 DeepSeek 提倡的变嫌肃穆力架构。从 V2 开动,MLA 使得 DeepSeek 在系列模子中终了资本大幅裁减,关联词缱绻、推感性能仍能与顶尖模子执平。

按照官方先容来说,FlashMLA 使用之后,H800 不错达到 3000GB/s 内存,终了 580TFLOPS 缱绻性能。

网友们纷纷点赞:向工程团队致以斯文的敬意,从 Hopper 的张量核中挤出了每一个 FLOP。这便是咱们将 LLM 劳动推向新前沿的口头!

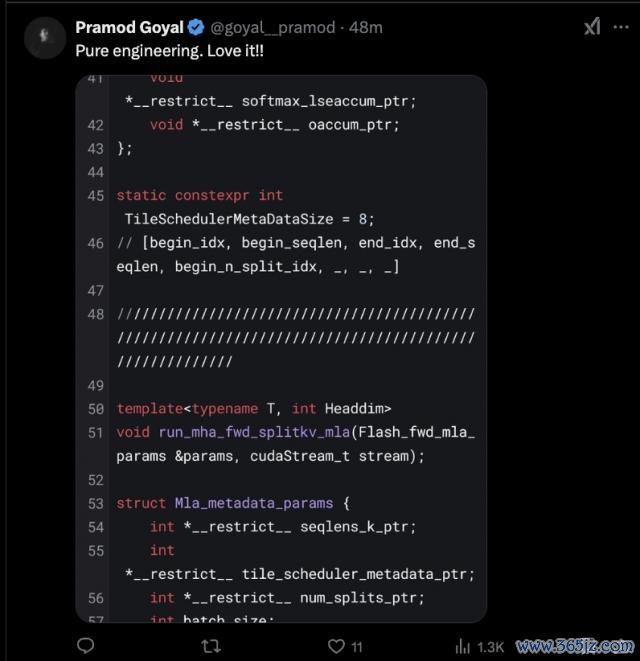

也曾有网友用上了。

开源第一天:FlashMLA

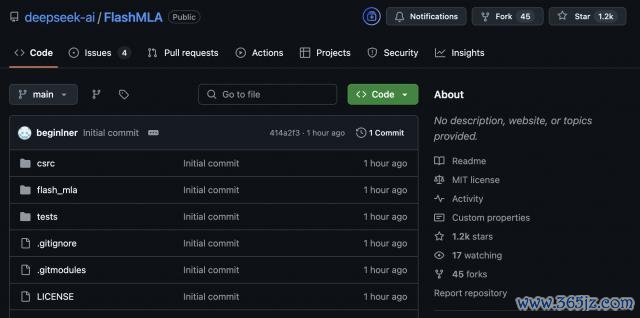

现在 GitHub 页面也曾更新。短短一小时,Star 星数也曾跨越 1.2k。

这次也曾发布:

守旧 BF16;

分页 KV 缓存,块大小为 64

快速启动:

环境条目:

Hopper GPU

CUDA 12.3 及以上版块

PyTorch 2.0 及以上版块

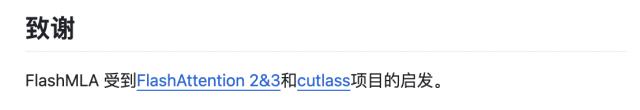

在项意见临了,它还暗意,这是受到了FlashAttention 2&3和英伟达 CUTLASS 项意见启发。

FlashAttention 是能终了快速且内存高效的精准肃穆力,主流大模子王人有在用。最新的第三代,不错让 H100 期骗率飙升至 75%。历练速率擢升 1.5-2 倍,FP16 下缱绻朦拢量高达 740TFLOPs/s,达表面最大朦拢量75%,更充分期骗缱绻资源,此前只可作念到 35%。

中枢作家是 Tri Dao,普林斯顿大牛,Together AI 的首席科学家。

而英伟达 CUTLASS 是 CUDA C++ 模板玄虚的聚首,用于在 CUDA 内终了高性能矩阵 - 矩阵乘法 ( GEMM ) 和所有级别和限制的有关缱绻。

MLA,DeepSeek 基本架构

临了再来说说,MLA,多头潜在肃穆力机制,DeepSeek 系列模子的基本架构,旨在优化 Transformer 模子的推理放肆与内存使用,同期保执模子性能。

它通过低秩谐和压缩本事,将多头肃穆力中的键(Key)和值(Value)矩阵投影到低维潜在空间,从而显耀减少键值缓存(KV Cache)的存储需求。这种顺序在长序列惩办中尤为病笃,因为传统顺序需要存储齐备的 KV 矩阵,而 MLA 通过压缩仅保留要害信息。

V2 版块中,这一变嫌性架构把显存占用降到了往常最常用的 MHA 架构的 5%-13%,终流露资本大幅裁减。它的推理资本仅为 Llama 370B 的 1/7、GPT-4 Turbo 的 1/70。

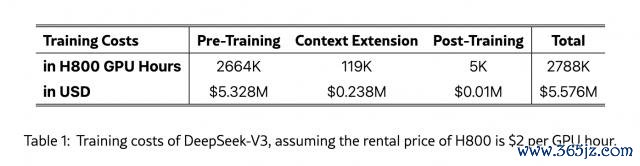

而在 V3,这一降本提速就更为流露,奏凯让 DeepSeek 诱骗民众眼神。

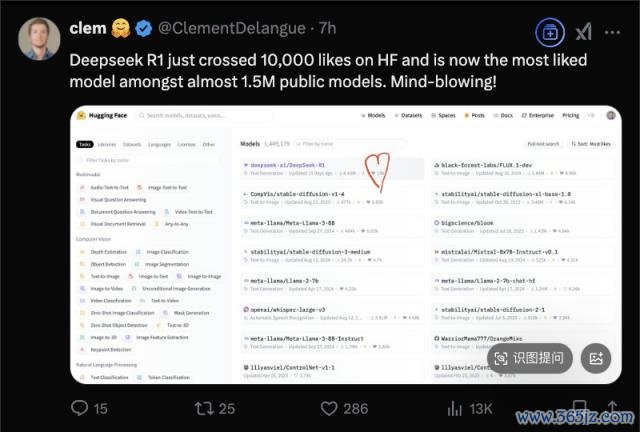

也就在今天,DeepSeek-R1 在 HuggingFace 上得到了跨越 10000 个赞,成为该平台近 150 万个模子之中最受海涵的大模子。

HuggingFace CEO 发文公布了这一佳音。

The whale is making waves!鲸鱼正在掀翻海浪!

好了期待一下,接下来的四天会发些什么呢?

GitHub 结合:

https://github.com/deepseek-ai/FlashMLA

参考结合:

https://x.com/deepseek_ai/status/1893836827574030466开云app官网下载入口